Ma már léteznek olyan innovatív megoldások, amelyek az AI-pszichiátria világát képviselik, ahol az mesterséges intelligencia nem csupán orvosi segédeszközként funkcionál, hanem a betegek szerepét is magára vállalja.

Amerikai tudósok egy innovatív megoldást dolgoztak ki, amely lehetővé teszi, hogy anélkül derüljön ki, mi okozott problémát egy mesterséges intelligencia rendszerben, hogy a kutatók hozzáférnének a rendszer belső, gyakran bizalmas információihoz.

Tudásukat tekintve lenyűgözőnek tűnhetnek a mesterséges intelligencia rendszerek, azonban előfordulhat, hogy nem egészen úgy működnek, ahogyan arra a tervezőik gondoltak, és persze meg is hibásodhatnak. Ezek pedig gondot jelentenek, miután egyre komolyabb feladatokat bíznak az ilyen algoritmusokra, robotokra.

Az mesterséges intelligencia meghibásodásának hátterében számos tényező állhat, például tervezési hiányosságok vagy a nem optimális betanítási adathalazs. Emellett a kódokban rejlő sebezhetőségek is lehetőséget adhatnak a hackereknek a kihasználásra. Ahhoz, hogy egy rendszert sikeresen javítani lehessen, elengedhetetlen tudni, mi okozza a problémát. A gond azonban az, hogy az ilyen rendszerek többsége nem ad egyértelmű támpontokat a meghibásodás okát illetően, és a bonyolultságuk miatt még a fejlesztők számára is kihívást jelenthet a hiba forrásának felderítése.

Természetesen léteznek olyan technikák, amelyek segítségével elemezni lehet az AI-rendszereket, de ezekhez elengedhetetlen a belső adatokhoz való hozzáférés, amit sok cég nem szívesen biztosít a külső szakértők számára. Emellett vannak forenzikus módszerek is, amelyek drónok, önvezető járművek és hasonló rendszerek meghibásodásaiból származó bizonyítékokat gyűjtenek. Azonban ezek a módszerek nem tudják megörökíteni azokat a nyomokat, amelyek a mesterséges intelligencia alapos vizsgálatához szükségesek. A helyzetet tovább bonyolítja, hogy a fejlett AI rendszerek képesek folyamatosan módosítani a döntéshozatali folyamataikat, ami végső soron megnehezíti vagy akár lehetetlenné teszi a vizsgálatukat a rendelkezésre álló eszközökkel.

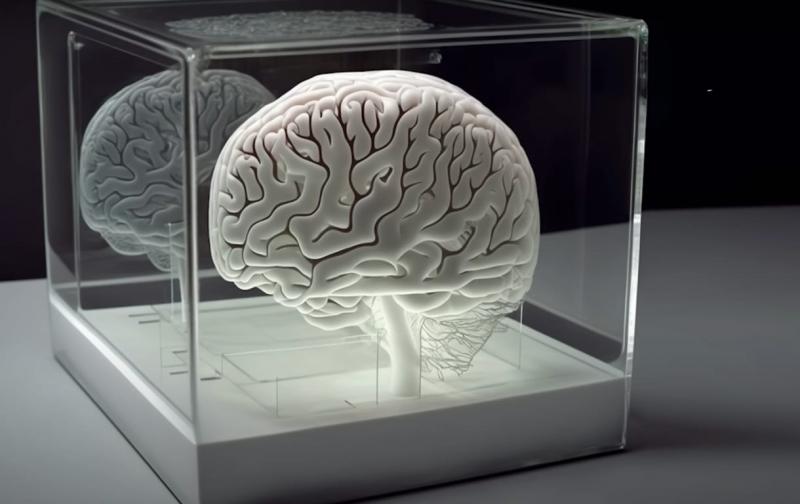

A Georgiai Műszaki Intézet kutatói egy innovatív megoldással rukkoltak elő, amely a problémák mélyebb megértését célozza meg: ezt a rendszert AI Psychiatrynak (AIP) nevezik. A hagyományos megközelítésektől eltérően az AIP nem csupán a hibás mesterséges intelligencia rendszerek diagnosztizálására összpontosít, hanem visszaállítja azokat az eredeti környezetükbe, ahol a meghibásodás bekövetkezett. A kutatók a The Conversation tudományos folyóiratban részletesen ismertették, hogy a rendszer képes „újraéleszteni” a problémás AI-modellt, lehetővé téve ezzel a szisztematikus tesztelést és a hibák alaposabb feltárását.

Az AI Psychiatry forenzikus algoritmusai a mesterséges intelligencia rendszerek döntéshozatali folyamataiban rejlő adatokat különítik el és elemzik. E folyamat során egy olyan funkcionális modellt alkotnak, amely hűen tükrözi az eredeti rendszert. Ezt követően a szakértők kontrollált környezetben "újra életre kelthetik" az AI-t, és szándékosan káros bemenetekkel tesztelhetik, hogy feltárják, mutat-e bármilyen káros vagy rejtett viselkedést.

A kutatók harminc mesterséges intelligencia modellt vizsgáltak meg, és közülük néhányat szándékosan "megfertőztek" különféle kihívásokkal. A rendszer sikeresen visszaállította, újratelepítette és alapos tesztelésnek vetette alá mindegyik modellt, beleértve azokat is, amelyeket a valós életben gyakran alkalmaznak, mint például az önvezető autók útjelző tábláinak azonosítását.

A szakértők véleménye szerint az eddigi kutatások arra engednek következtetni, hogy az AI Psychiatry rendkívül hatékonyan képes feltárni azokat a digitális rejtélyeket, amelyek az önvezető autók balesetei mögött húzódnak. Eddig ezek az esetek számos megválaszolatlan kérdést hagytak maguk után, sokkal inkább, mint ahány választ adtak. Amennyiben az AI Psychiatry nem fedez fel sebezhetőséget az autók mesterséges intelligencia rendszerében, ez lehetőséget teremt arra, hogy kizárják a MI hibáját, és más lehetséges okokra, például egy meghibásodott kamerára tereljék a figyelmet.

Az AI Psychiatry alkalmazása nem csupán az önvezető autók területén korlátozódik. Az alapjául szolgáló algoritmus generikus jellegű, hiszen olyan univerzális elemekre összpontosít, amelyek minden AI-modell elengedhetetlen részét képezik a döntéshozatali folyamat során. E megközelítés révén az amerikai kutatók által kifejlesztett rendszer könnyedén alkalmazható bármely olyan AI-modellre, amely elterjedt fejlesztési keretrendszereket használ. Mindenki, aki egy potenciális AI-hiba elemzésével foglalkozik, kihasználhatja ezt a platformot egy modell értékelésére, anélkül hogy előzetesen tisztában lenne annak részletes architektúrájával – állítják a kutatók. Továbbá, hangsúlyozzák, hogy újításuk nyílt forráskódú, elérhető a GitHubon is, így bárki számára hozzáférhetővé válik.